群联在 GTC 2024 的展位上带来了意想不到的惊喜:该公司演示了一个带有四个 GPU 的工作站,使用 SSD 和 DRAM 来扩展 AI 工作负载的有效内存空间,使其能够运行通常需要 1.4TB VRAM 的工作负载,分布在 24 H100 上GPU。该公司的新aiDaptiv+平台旨在通过使用系统DRAM和SSD来增加可用于训练的GPU VRAM的数量,从而降低AI LLM培训的门槛,群联表示这将使用户能够以极低的成本完成密集的生成式AI培训工作负载。尽管以较低的入门成本换取了性能的降低和训练时间的延长,但仅使用标准 GPU 的成本仍然很高。

对于使用这种类型部署的企业来说,好处是可以降低成本,避免继续困扰行业的 GPU 严重短缺,还可以使用在本地训练的开源模型,从而允许他们保留敏感的私人数据内部。群联及其合作伙伴将该平台瞄准中小企业和其他用户,他们不太关心法学硕士的整体培训时间,但可以从使用现成的预训练模型并在自己的私人数据集上对其进行培训中受益。

该公司的演示是该技术的有力证明,展示了一个配备四个 Nvidia RTX 6000 Ada A100 GPU 的工作站,运行着 700 亿个参数模型。较大的 AI 模型更准确,可提供更好的结果,但群联估计,这种规模的模型通常需要约 1.4 TB 的 VRAM,分布在服务器机架中六台服务器上的 24 个 AI GPU 上,以及所需的所有支持网络和硬件。

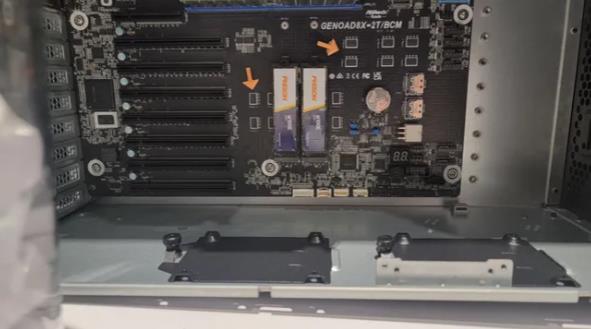

群联的 aiDaptiv+ 解决方案使用中间件软件库,从 VRAM 中“切掉”未主动计算的 AI 模型层,并将其发送到系统 DRAM。如果需要的话,数据可以保留在 DRAM 中,或者如果优先级较低,则可以将其刷新到 SSD。然后,数据会根据需要被调用并移回到 GPU VRAM 中以执行计算任务,同时新处理的层会刷新到 DRAM 和 SSD 中,为下一层的处理腾出空间。群联电子使用Maingear 的全新 Pro AI 工作站

进行演示。该演示系统配备了 Xeon w7-3435X 处理器、512GB DDR5-5600 内存和两个专用 2TB Phison SSD。然而,它们有多种款式,从 1 个 GPU 的 28,000 美元到有 4 个 GPU 的系统的 60,000 美元不等。当然,这只是将六到八个 GPU 训练服务器与所有必需的网络组合在一起所需的数量的一小部分。此外,这些系统将在单个 15A 电路上运行,而服务器机架则需要更强大的电气基础设施。

Maingear是群联新平台的主要硬件合作伙伴,但该公司还有许多其他合作伙伴,包括微星、技嘉、华硕和Deep Mentor,他们也将为新平台提供解决方案。

Phison 的新款 aiDaptiveCache ai100E SSD 采用标准 M.2 外形尺寸,但专为缓存工作负载而设计。群联尚未分享这些 SSD 的深入细节,但我们确实知道它们使用 SLC 闪存来提高性能和耐用性。这些驱动器的额定容量为五年内每天 100 次驱动器写入,与标准 SSD 相比,其耐用性非常出色。

正如您在上面的幻灯片中看到的,aiDaptive+ 中间件位于 Pytorch/Tensor Flow 层下方。群联表示,中间件是透明的,不需要修改人工智能应用程序。

使用单个工作站完成此类培训课程显然会大大降低成本,但确实会牺牲性能。Phison 预测,这种单一设置比训练分布在 8 个节点上的 30 个 GPU 的大型模型的成本低六倍,但模型的训练时间将花费大约四倍的时间。该公司还提供横向扩展选项,以一半多一点的成本将四个节点连接在一起,据称这可以将 70B 模型的训练时间缩短至 1.2 小时,而 30-GPU 系统的训练时间为 0.8 小时。

此举标志着群联从创建SSD控制器和重定时器的标准模型扩展到提供新的混合软件和硬件解决方案,通过大幅降低整体解决方案的成本来提高AI LLM培训的可及性。群联有许多合作伙伴将新软件的系统推向市场,我们预计在未来几个月会看到更多公告。与往常一样,性能证明将在第三方基准测试中进行,但随着系统现在向群联的客户过滤,可能用不了多久我们就会看到一些现实世界的例子。